PERUGIA – Qual è il miglior modo per elaborare, archiviare, memorizzare e integrare dati su pc, smartphone o altri dispositivi? Oggi vi parliamo di Cloud Computing e Data Science, due risposte interessanti alla crescente domanda di capacità di calcolo, di memorizzazione e di flessibilità. A tal proposito, abbiamo intervistato Rossella De Gaetano, dopo un corso tenuto all’Università di Perugia.

L’altro giorno ho incontrato Rossella all’uscita dell’università di Perugia. Mi è sembrata stanca, ma allo stesso tempo raggiante. Ho pensato che avesse fatto una delle sue coinvolgenti presentazioni, invece…

Ciao, Rossella! Come mai da queste parti?

Ciao, Fabiola! Ho appena finito di insegnare Cloud Computing

Cloud Computing? Insegnate? Tu? Non sapevo facessi anche questo.

Cloud Computing? Insegnate? Tu? Non sapevo facessi anche questo.

Be’, in realtà è la prima volta che insegno all’università. E’ iniziato tutto quasi per caso verso la fine dello scorso anno. Il mio manager mi ha chiesto se fossi disposta ad insegnare in un corso all’interno di un master universitario come parte di una cooperazione azienda-università. Sinceramente, ho sempre sognato di insegnare e quindi, senza pensarci piu’ di tanto, ho accettato. Solo qualche giorno dopo ho pensato “e se non fossi padrona dell’argomento?…A proposito, quale è l’argomento?” Torno dal mio manager per chiedere qualche dettaglio in piu’. Mi spiega che il master è sulla Data Science (per info cliccate qui) e che avevano pensato a me per il corso di Cloud Computing. Bellissimo!!! Sono anni che lavoro sull’argomento ed ho subito pensato che la mia esperienza avrebbe potuto dare un contributo significativamente pratico.

Mi sembra che la cosa ti abbia catturato sin dal principio, ti vedo entusiasta. Ma dimmi qualcosa in piu’ sulla Data Science, di che si tratta?

La data science si occupa di estrarre dal mare magnum di dati strutturati e non strutturati che quotidianamente aziende e privati cittadini producono, informazioni che possano portare vantaggi competitivi per le aziende, ottimizzazioni nei processi, migliore conoscenza dei clienti e chi più ne ha più ne metta. Mi piace pensare al data scientist come un moderno Sherlock Holmes che naviga in un oceano di bit facendo ipotesi che spieghino trend e comportamenti che osserva nei dati. La difficoltà nel lavoro del data scientist è l’avere a che fare con molte discipline eterogenee: deve saper passare dal marketing alle logiche di usabilità delle interfacce grafiche, dall’umore dei consumatori del prodotto X sui social ai dati sulla qualità dello stesso e su suoi tempi di distribuzione e supporto. E’ un lavoro che richiede molta creatività e competenza. I dati di per se’ non dicono nulla, sta alla abilità del data scientist l’identificare pattern, nel proporre le opportune domane e nel formulare le adeguate ipotesi. Ipotesi che poi verranno validate analizzando un’altra mole di dati… E’ un circolo virtuoso che una volta innescato appropriatamente porta a scoprire dettagli talvolta sorprendenti su come un prodotto od un servizio viene consumato e perché.

Interessante!…Ma cosa ha a che fare col Cloud Computing?

Il processamento e l’analisi di queste enormi moli di dati (non per niente si parla di Big Data) ha bisogno di grande potenza di calcolo e di software adeguato per conservarli e manipolarli. Il Cloud offre non solo la disponibilità di risorse potenzialmente infinite (il limite è posto tipicamente solo dalla carta di credito), ma anche l’elasticità necessaria ad usufruire di una maggiore potenza di calcolo e spazio disco solo quando è necessario, il tutto in modalità “self service” e “pay as you go”. L’altra cosa carina dell’usare il cloud è che ti permette di sperimentare nuovi tools e database senza dover perdere tempo ad installarli e configurarli. Ad esempio un software che va per la maggiore per l’analisi dei big data è spark: usando un cloud pubblico tipo IBM Bluemix in pochi minuti lo avrete istanziato e configurato e sarete pronti a metterci dentro i dati ed a scrivere query e reports.

Capito! Da quello che mi stai raccontando, il data scientist deve essere una specie di tuttologo che riesce a districarsi in vari ambiti e tecnologie, una specie di superman!

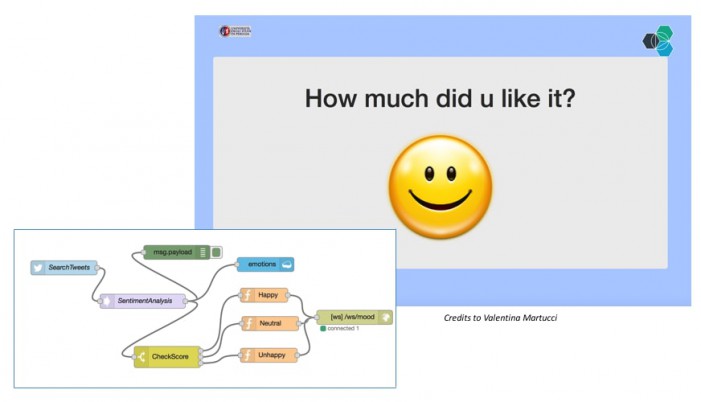

Ah ah ah! Si’, man mano che ci si addentra nell’argomento sembra che altri dettagli vengano fuori, ci sono altre cose da imparare, nuovi insights da scoprire… non per niente qualcuno ha definito di recente il data scientist come il lavoro piu’ sexy del ventunesimo secolo. Per fortuna, al giorno d’oggi ci sono molti strumenti, sia opensource che proprietari, che permettono al data scientist di astrarsi dal conoscere in dettaglio tutte le tecnologie. Ad esempio, uno degli esercizi che ho proposto agli studenti a fine corso è quello di costruire una applicazione che permettesse di avere feedback sul corso leggendo un hashtag da twitter. Non tutti gli studenti avevano skill di programmazione. L’esercizio includeva la necessità di capire l’umore del tweet, quindi l’uso di un qualche algoritmo di machine learning e di natural language processing, la necessità di conservare i dati, chiaramente non strutturati, per fare poi dei report storici. In un paio di ore, usando la piattaforma Node-Red, il database non relazionale cloudant ed i moduli predefiniti disponibili su IBM Bluemix (e.g. twitter insight), gli studenti sono riusciti a costruire, dopo una infarinatura di 15 minuti sul linguaggio di programmazione javascript, l’applicazione richiesta. Insomma, con uno sforzo relativamente piccolo e con i giusti tool si può riuscire in tempo rapido ad avere grandi risultati.

Mi viene quasi quasi voglia di provarlo! Ma dimmi, qualcosa in piu’ sugli studenti, erano tutti neo laureati?

No, c’erano un paio di ragazzi che avevano appena finito la laurea magistrale, ma la maggior parte dei partecipanti erano professionisti ansiosi di migliorare ed aggiornare le loro competenze. Io ho interpretato questo come un chiaro sintomo che ormai, anche in Italia, la figura del data scientist è richiesta ed importante.

Ripeteresti l’esperienza? Credi che sia stato utile?

Decisamente si’! Una volta entrati nel mondo del lavoro, ci si tende a specializzare in maniera talvolta estrema e si perde un po’ il contatto col resto dell’universo che intanto si evolve: con la tecnologia anche i metodi di insegnamento cambiano. Un corso come quello che io ho tenuto, di 28 ore, che attraversasse tematiche generali su Cloud Computing ed esercitazioni pratiche su software opensource come OpenStack o Cloud Foundry piuttosto che proprietario come IBM Bluemix, qualche anno fa avrebbe richiesto mesi per raggiungere gli stessi risultati. La possibilità di interfacciarmi con altri professionisti per avere uno spaccato di prima mano su ciò che richiede il mercato e come gli altri affrontano il lavoro quotidianamente dal mio punto di vista è impagabile.

Dal lato degli studenti e degli organizzatori del master, spero abbiano apprezzato il taglio ultra pratico del corso volto a condividere esperienze reali, a produrre artifatti ed a sperimentare metodologie che spero tornino utile nella vita lavorativa quotidiana e che aiutino anche all’orientamento dei futuri corsi universitari per renderli sempre piu’ adeguati e calzanti alla offerta di lavoro.

Dal lato degli studenti e degli organizzatori del master, spero abbiano apprezzato il taglio ultra pratico del corso volto a condividere esperienze reali, a produrre artifatti ed a sperimentare metodologie che spero tornino utile nella vita lavorativa quotidiana e che aiutino anche all’orientamento dei futuri corsi universitari per renderli sempre piu’ adeguati e calzanti alla offerta di lavoro.

- Casa-museo Giovanni Gentiletti: Consiglio artistico per la terza domenica del mese – 18 Aprile 2024

- A Pesaro incontro con lo Chef stellato Stefano Ciotti – 15 Aprile 2024

- Summer in Italy e le tendenze Collezioni Primavera Estate 2024 – 12 Aprile 2024